Dify 上的 Ollama 不支持 Rerank 模型

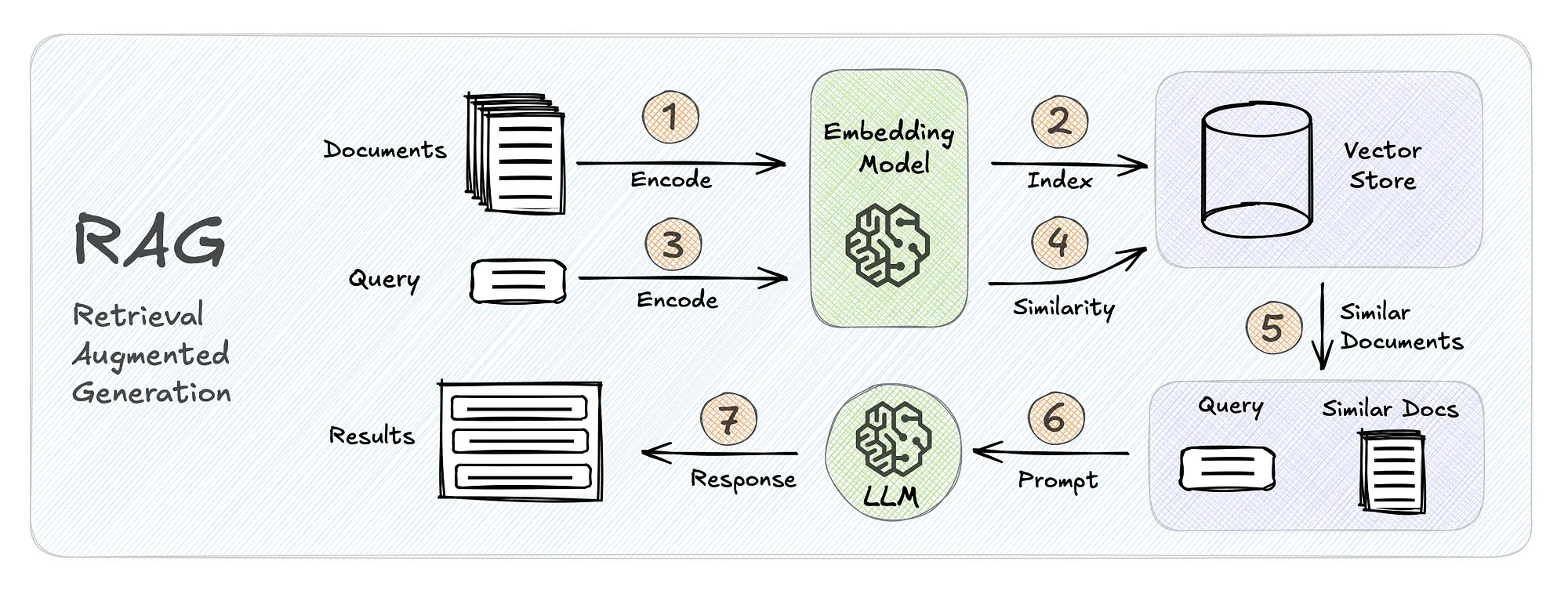

在 Dify Cloud 平台调用各大平台的大模型 API 一直都没发现这个问题,随着开始折腾本地化使用,才发现 Ollama 部署大模型虽然方便,但是 RAG 中 Dify 知识库混合检索,需要 Rerank 模型时,这一点上,Ollama 居然是不支持 Rerank 模型的。

Dify Cloud 的系统模型设置,在接入了阿里云百炼的通义千问 API Key 后,Rerank 模型会默认显示通义千问的 gte-rerank 和 gte-rerank-v2。

本地部署 Ollama + Dify,在 Dify 选择 Ollama 模型供应商,发现 Ollama 只支持 LLM 和 Text Embedding,不支持 Rerank 模型。

看到有提到使用 Xinference 平台来部署 Rerank 模型的,特意去看了一下 Xorbits Inference,发现的确是除了 LLM 和 Text Embedding 还支持 Rerank、Speech2text、TTS。